Microsoft zaprezentował Maia 200, własny, superwydajny procesor AI zaprojektowany z myślą o dużych modelach językowych. Nowy chip ma realnie przyspieszyć działanie systemów takich jak ChatGPT i Microsoft 365 Copilot, jednocześnie obniżając koszty ich utrzymania w chmurze Azure.

Microsoft stawia na własny hardware AI

Microsoft od kilku lat konsekwentnie buduje własną infrastrukturę dla sztucznej inteligencji, a Maia 200 jest kolejnym, bardzo wyraźnym krokiem w tym kierunku. To nie jest uniwersalny procesor ani klasyczna karta akceleracyjna. Układ powstał z myślą o konkretnych zadaniach: inferencji i trenowaniu dużych modeli językowych, które dziś napędzają usługi AI w chmurze.

Maia 200 została wykonana w litografii 3 nm i zawiera ponad 140 miliardów tranzystorów. Kluczowe jest jednak coś innego, pełna optymalizacja pod niskoprecyzyjne obliczenia FP4 i FP8. To właśnie takie formaty dominują dziś w generatywnej sztucznej inteligencji, bo pozwalają znacząco zwiększyć wydajność bez utraty jakości wyników.

Moc obliczeniowa i pamięć robią różnicę

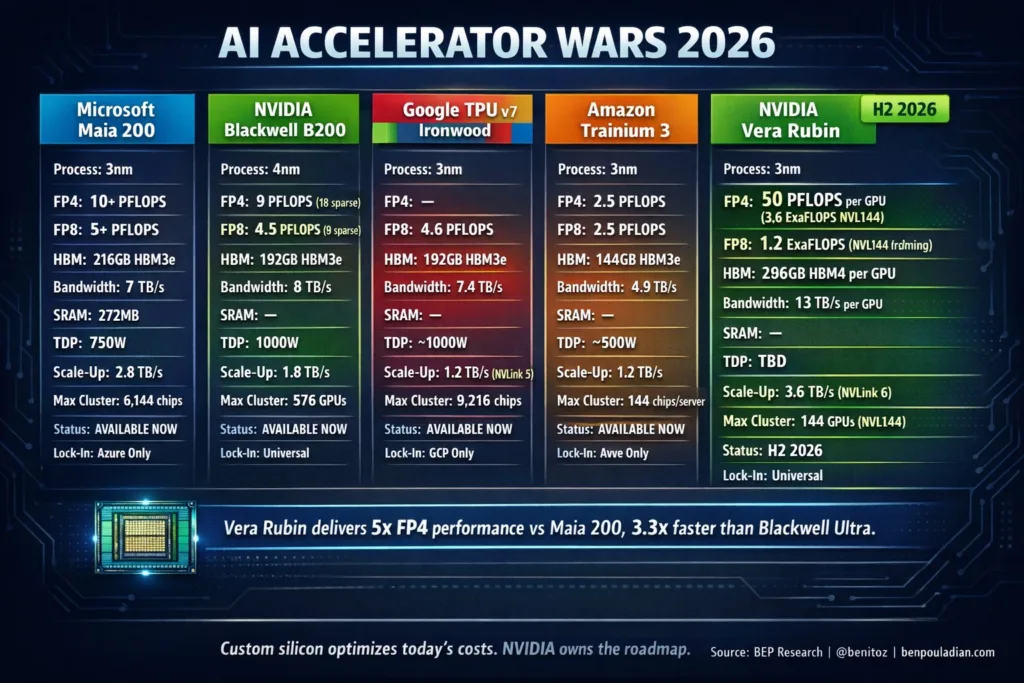

Microsoft chwali się, że jeden układ Maia 200 osiąga ponad 10 petaFLOPS w obliczeniach 4-bitowych oraz ponad 5 petaFLOPS w 8-bitach. W praktyce oznacza to możliwość obsługi bardzo dużych modeli przy niższym zużyciu energii i mniejszych opóźnieniach.

Równie ważna jest pamięć. Maia 200 otrzymała aż 216 GB HBM3e o przepustowości 7 TB/s oraz 272 MB szybkiej pamięci SRAM na samym chipie. Innymi słowy, dane trafiają do rdzeni obliczeniowych bez wąskich gardeł, a generowanie kolejnych tokenów odbywa się szybciej i stabilniej. Dla użytkowników końcowych przekłada się to na krótszy czas oczekiwania na odpowiedź AI.

Porównanie z konkurencją chmurową

Microsoft otwarcie porównuje Maia 200 z rozwiązaniami Amazonu i Google’a. W zestawieniu z AWS Trainium 3 nowy chip oferuje około trzykrotnie wyższą wydajność w FP4, a w FP8 wyprzedza Google TPU v7. Co więcej, firma deklaruje nawet 30-procentową poprawę wskaźnika „wydajność na dolara” względem dotychczas wykorzystywanego sprzętu w Azure.

To ważny sygnał, bo walka w chmurze AI toczy się dziś nie tylko o surową moc, ale też o koszty. Tańsza inferencja oznacza, że usługi oparte na AI mogą być skalowane szerzej, również dla mniejszych firm i deweloperów.

Cały system zaprojektowany od zera

Maia 200 jest elementem większej całości. Microsoft projektuje jednocześnie chip, pamięć, sieć i oprogramowanie. Każdy układ dysponuje 2,8 TB/s dedykowanej przepustowości sieciowej i może pracować w klastrach liczących do 6144 akceleratorów. Dzięki temu infrastruktura rośnie bez gwałtownych spadków wydajności.

Dodatkowo Microsoft udostępnia Maia SDK z integracją m.in. z PyTorch, kompilatorem Triton i zestawem zoptymalizowanych kernelów. To ułatwia przenoszenie modeli między różnymi akceleratorami i wyciskanie maksimum możliwości z nowego chipu.

Co to oznacza dla użytkowników?

Maia 200 już działa w regionie Azure US Central, a kolejne centra danych są w przygotowaniu. Układ będzie obsługiwał najnowsze modele OpenAI, w tym kolejne wersje GPT, a także Copilota i usługi Microsoft Foundry. W efekcie odpowiedzi AI mają być szybsze, stabilniejsze i tańsze w utrzymaniu.

Podsumowanie

Microsoft Maia 200 to nie tylko nowy procesor, ale fundament pod kolejną generację usług AI w chmurze. Jeśli zapowiedzi się potwierdzą, Microsoft zyska realną przewagę infrastrukturalną nad konkurencją. Pytanie brzmi jedno, jak szybko użytkownicy końcowi odczują tę zmianę w codziennym korzystaniu z ChatGPT i Copilota?